内容目录

- • 深度学习与机器学习接单服务开发指南 🔍

- —— 确定需求分析

- —— 构建基础环境

- —— 设计API接口

- —— 训练与部署模型

- • 爬虫调试技巧 ✨

- —— 遵守robots协议

- —— 处理反爬机制

- —— 数据清洗与预处理

- • 常见问题及解决方案 ❓

- —— Q1: 如何解决模型过拟合的问题?

- —— Q2: 如果遇到爬虫效率低下的情况怎么办?

- —— Q3: 怎样保证代码质量和可维护性?

- • 实用技巧与提示 ✨

- —— 日志记录与监控

- —— 社区交流

- —— 持续学习

- • 结论

随着人工智能技术的快速发展,越来越多的企业和个人开始寻求专业的Python深度学习和机器学习(DL/ML)解决方案。与此同时,数据采集成为了构建高效模型不可或缺的一部分。本文将详细介绍如何编写高质量的DL/ML接单服务代码以及进行爬虫调试,帮助你在这个充满机遇的领域中脱颖而出。

![图片[1]-Python深度学习与机器学习接单服务及爬虫调试全攻略-连界优站](https://www.6x66.cn/wp-content/uploads/2024/10/image-170.png)

深度学习与机器学习接单服务开发指南 🔍

确定需求分析

在承接任何项目之前,首先要明确客户的具体要求,包括但不限于:问题描述、预期成果、可用资源等。这一步骤至关重要,因为它直接关系到后续工作的方向和技术选型。

示例对话:与客户的初次沟通

客户: 我们希望用深度学习来预测股市走势。

开发者: 了解了,请问您是否有历史交易数据?对于准确率有何期望?构建基础环境

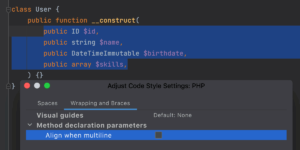

确保安装了所有必要的依赖库,并配置好开发环境。推荐使用Anaconda管理包版本,这样可以简化跨平台兼容性问题。

示例代码:创建虚拟环境并安装常用库

conda create --name ml_service python=3.8

conda activate ml_service

pip install numpy pandas scikit-learn tensorflow keras flask设计API接口

为便于集成和服务调用,建议采用RESTful API风格设计Web服务端点。Flask框架以其轻量级和灵活性著称,非常适合快速搭建原型系统。

示例代码:定义简单的Flask路由

from flask import Flask, request, jsonify

app = Flask(__name__)

@app.route('/predict', methods=['POST'])

def predict():

data = request.get_json()

# 处理输入数据...

result = {"prediction": "example"}

return jsonify(result)

if __name__ == '__main__':

app.run(debug=True)训练与部署模型

选择合适的算法或预训练模型作为起点,根据业务场景调整超参数直至达到满意的性能指标。然后将训练好的模型序列化保存,以便在线推理时加载使用。

示例代码:保存Keras模型

model.save('my_model.h5')

# 加载已保存模型

from tensorflow.keras.models import load_model

loaded_model = load_model('my_model.h5')爬虫调试技巧 ✨

遵守robots协议

在抓取网站内容前,务必检查目标站点提供的robots.txt文件,确认允许访问哪些页面路径。这是尊重版权和避免法律风险的基本原则。

处理反爬机制

现代网站为了防止恶意爬取,通常会设置各种防护措施,如验证码、IP封禁等。针对这种情况,我们可以采取以下几种方法应对:

- 模拟浏览器行为 – 使用Selenium等工具模仿真实用户的操作习惯。

- 随机延时请求 – 设置合理的等待间隔时间,降低被识别为自动化程序的可能性。

- 更换User-Agent头信息 – 修改HTTP请求头部中的标识符,使其看起来像是来自不同的浏览器类型。

示例代码:自定义请求头

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36',

}

response = requests.get('https://example.com', headers=headers)

print(response.text)数据清洗与预处理

获取到原始网页后,往往需要经过一系列转换才能用于进一步分析。BeautifulSoup是一个非常流行的HTML解析库,能够轻松提取出表格、文本等内容;而Pandas则擅长处理结构化数据,支持多种格式之间的相互转换。

示例代码:解析HTML表格

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_content, 'html.parser')

table = soup.find('table')

rows = table.find_all('tr')

for row in rows:

columns = row.find_all('td')

print([ele.text.strip() for ele in columns])常见问题及解决方案 ❓

Q1: 如何解决模型过拟合的问题?

增加正则化项(L1/L2)、引入Dropout层或者扩大训练集规模都是有效的缓解手段;此外还可以尝试交叉验证评估模型泛化能力。

Q2: 如果遇到爬虫效率低下的情况怎么办?

优化XPath/CSS选择器表达式提高匹配精度;利用多线程或多进程并发执行多个请求任务;考虑启用缓存机制减少不必要的重复查询。

Q3: 怎样保证代码质量和可维护性?

遵循PEP8编码规范保持一致的格式风格;编写单元测试覆盖核心逻辑部分;定期重构冗长复杂的函数以增强可读性。

实用技巧与提示 ✨

日志记录与监控

开启详细的日志输出有助于追踪程序执行过程中的每一个细节,便于快速定位故障点。可以通过修改配置文件或编程接口设置日志级别。

社区交流

积极参与国内外知名的技术论坛和技术交流群组,分享自己的经验和遇到的挑战,往往能够获得意想不到的帮助和支持。

持续学习

随着Python语言特性和相关库的发展,保持对新技术的关注至关重要。定期查阅官方文档、参加在线课程或研讨会都是不错的选择,有助于紧跟潮流并应用于实践当中。

结论

通过这篇详细的教程,我们学习了Python深度学习与机器学习接单服务的编写要点以及爬虫调试的最佳实践,掌握了具体的应用步骤和优化建议。无论你是初学者还是有一定经验的开发者,这些知识都能为你带来启发并应用于实际项目中。如果有任何疑问或需要进一步的帮助,请随时留言讨论!💬

暂无评论内容