内容目录

- • 准备工作 🔧

- —— 安装与配置环境

- —— 启动 Spark 集群(可选)

- • 构建网络字节流统计分析程序 ✨

- —— 创建 StreamingContext 对象

- —— 定义输入 DStream

- —— 数据预处理与转换

- —— 实施统计逻辑

- —— 启动 StreamingContext

- • 常见问题及解决方案 ❓

- —— Q1: 如何处理数据丢失或延迟?

- —— Q2: 遇到性能瓶颈怎么办?

- —— Q3: 怎样监控程序运行状况?

- • 实用技巧与提示 ✨

- —— 日志记录与调试

- —— 社区交流

- —— 持续学习

- • 结论

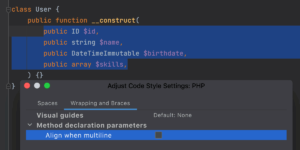

在大数据处理领域,实时数据流分析变得越来越重要。PySpark Streaming 提供了一个强大的框架来处理这种持续流入的数据。本文将详细介绍如何使用 PySpark 3.4.4 的 StreamingContext 来实现对网络字节流的统计分析,帮助你更好地理解和应用这一技术。

![图片[1]-PySpark 3.4.4 实现基于StreamingContext的网络字节流统计分析-连界优站](https://www.6x66.cn/wp-content/uploads/2024/12/20230830.png)

准备工作 🔧

安装与配置环境

确保你的环境中已经安装了 Apache Spark,并且版本不低于 3.4.4。此外,还需要 Python 和 PySpark 库的支持。可以通过 pip 安装 PySpark:

pip install pyspark启动 Spark 集群(可选)

如果你打算在一个分布式集群上运行代码,请按照官方文档启动 Spark 集群。对于本地开发和测试,直接在单机模式下运行即可满足需求。

构建网络字节流统计分析程序 ✨

创建 StreamingContext 对象

首先需要创建一个 StreamingContext 实例作为所有流式计算的基础。这里我们指定批处理间隔为 1 秒钟,这意味着每秒钟会从源中抽取一批新到达的数据进行处理。

示例代码:初始化 StreamingContext

from pyspark import SparkConf, SparkContext

from pyspark.streaming import StreamingContext

# 设置 Spark 配置参数

conf = SparkConf().setAppName("NetworkBytesStats").setMaster("local[*]")

sc = SparkContext(conf=conf)

# 创建 StreamingContext 并设置批次间隔时间为 1 秒

ssc = StreamingContext(sc, batchDuration=1)定义输入 DStream

接下来定义用于接收网络字节流的 DStream。这里以 TCP Socket 为例,通过监听特定端口获取外部发送过来的数据包。

示例代码:定义输入 DStream

# 监听本地 9999 端口上的连接请求

lines = ssc.socketTextStream("localhost", 9999)数据预处理与转换

由于接收到的数据可能是未格式化的原始字节串,因此需要对其进行适当的清洗和解析,以便后续统计分析。假设每个数据包包含一行文本,我们可以简单地按行分割并过滤掉空行。

示例代码:预处理输入数据

# 按行拆分数据并去除空白行

data = lines.flatMap(lambda line: line.split("\n")).filter(lambda x: len(x.strip()) > 0)实施统计逻辑

根据业务需求设计具体的统计规则,如计算总字节数、平均大小等。下面的例子展示了如何统计一段时间内收到的所有数据包的总长度。

示例代码:统计总字节数

# 计算每条记录的字节长度

byteCounts = data.map(lambda x: len(x.encode('utf-8')))

# 聚合得到每批次内的总字节数

totalBytes = byteCounts.reduce(lambda a, b: a + b)

# 打印结果

totalBytes.pprint()启动 StreamingContext

完成上述步骤后,调用 start() 方法开始接收数据并执行相应的处理任务;同时调用 awaitTermination() 方法保持程序处于运行状态直到手动终止。

示例代码:启动 StreamingContext

ssc.start() # 开始接收数据并处理

ssc.awaitTermination() # 等待终止信号常见问题及解决方案 ❓

Q1: 如何处理数据丢失或延迟?

为了保证数据完整性和时效性,可以考虑启用检查点机制保存中间状态信息,或者调整批处理间隔时间以适应不同速率的数据流。

Q2: 遇到性能瓶颈怎么办?

优化方案包括但不限于增加节点数量扩展集群规模、合理分配资源避免争用、以及精简不必要的操作减少计算开销。

Q3: 怎样监控程序运行状况?

利用 Spark UI 提供的可视化界面查看作业进度、任务分布等情况,及时发现潜在问题并作出相应调整。

实用技巧与提示 ✨

日志记录与调试

开启详细的日志输出有助于追踪程序执行过程中的每一个细节,便于快速定位故障点。可以通过修改配置文件或编程接口设置日志级别。

社区交流

积极参与国内外知名的技术论坛和技术交流群组,分享自己的经验和遇到的挑战,往往能够获得意想不到的帮助和支持。

持续学习

随着大数据处理技术和工具集的发展,保持对新技术的关注至关重要。定期查阅官方文档、参加在线课程或研讨会都是不错的选择,有助于紧跟潮流并应用于实践当中。

结论

通过这篇详细的教程,我们学习了如何使用 PySpark 3.4.4 的 StreamingContext 来构建一个简单的网络字节流统计分析系统。无论你是初学者还是有一定经验的开发者,这些知识都能为你带来启发并应用于实际项目中。如果有任何疑问或需要进一步的帮助,请随时留言讨论!💬

暂无评论内容