内容目录

- • Graph Transformer概述 🔍

- —— 什么是Graph Transformer?

- —— 关键组件解析

- • 实现细节与技术要点 ✨

- —— 数据预处理

- —— 模型训练策略

- • 工程应用案例 🛠️

- —— 社交媒体影响力预测

- —— 化学物质性质预测

- —— 推荐系统改进

- • 常见问题及解决方案 ❓

- —— Q1: 如何处理大规模图数据?

- —— Q2: 遇到冷启动问题怎么办?

- —— Q3: 如何评估模型性能?

- • 实用技巧与提示 ✨

- —— 调试与验证

- —— 性能调优

- —— 社区交流

- • 结论

图神经网络(GNN)作为处理非欧几里得结构数据的强大工具,在社交网络分析、推荐系统、化学分子建模等多个领域展现出了卓越的能力。近年来,结合Transformer架构的Graph Transformer更是为这一领域带来了革命性的变化。本文将深入探讨Graph Transformer的工作原理,并介绍其在实际工程项目中的应用场景。

![图片[1]-图神经网络深度解析:Graph Transformer算法及其工程应用-连界优站](https://www.6x66.cn/wp-content/uploads/2024/12/20230830.png)

Graph Transformer概述 🔍

什么是Graph Transformer?

Graph Transformer是将经典的Transformer模型应用于图结构数据的一种扩展形式。它保留了原始Transformer中自注意力机制的核心思想,同时引入了针对图的独特设计,如节点特征编码、边权重调整等,以更好地捕捉图中的复杂关系。

关键组件解析

- 节点嵌入层 – 将每个节点的属性信息映射到高维空间,形成初始表示向量。

- 多头注意力机制 – 允许模型从不同角度关注邻居节点之间的联系,增强表达能力。

- 位置编码 – 解决图中缺乏顺序信息的问题,通过添加额外的位置信号来辅助学习。

- 聚合与更新模块 – 综合考虑来自邻近节点的信息,迭代地更新当前节点的状态。

实现细节与技术要点 ✨

数据预处理

为了使Graph Transformer能够有效地工作,输入数据必须经过适当的预处理:

- 标准化节点特征 – 确保所有节点在同一尺度上进行比较,避免某些特征主导其他特征。

- 构建邻接矩阵或边列表 – 描述图中节点间的连接情况,用于指导注意力计算过程。

- 生成掩码向量 – 当存在缺失值或需要限制注意力范围时使用。

模型训练策略

- 损失函数选择 – 根据具体任务确定合适的优化目标,如分类问题常用的交叉熵损失。

- 正则化方法 – 添加L2惩罚项或Dropout层防止过拟合现象发生。

- 批量归一化 – 加速收敛速度并提高泛化性能。

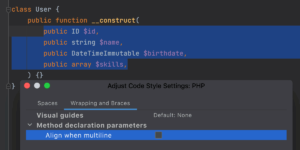

示例代码:构建简单的Graph Transformer模型

import torch

import torch.nn.functional as F

from torch_geometric.nn import GATConv

class SimpleGraphTransformer(torch.nn.Module):

def __init__(self, in_channels, hidden_channels, out_channels, num_heads=4):

super(SimpleGraphTransformer, self).__init__()

self.conv1 = GATConv(in_channels, hidden_channels, heads=num_heads)

self.conv2 = GATConv(hidden_channels * num_heads, out_channels)

def forward(self, x, edge_index):

x = F.dropout(x, p=0.6, training=self.training)

x = self.conv1(x, edge_index)

x = F.elu(x)

x = F.dropout(x, p=0.6, training=self.training)

x = self.conv2(x, edge_index)

return F.log_softmax(x, dim=1)工程应用案例 🛠️

社交媒体影响力预测

利用Graph Transformer可以对用户之间的交互行为建模,进而预测哪些人具有较高的传播力和影响力。例如,在微博平台上识别出潜在的意见领袖,帮助广告商精准投放营销内容。

化学物质性质预测

对于新药研发而言,准确预测化合物的生物活性至关重要。Graph Transformer能够基于分子图谱自动提取特征,并且结合实验数据进行回归分析,从而加快药物发现进程。

推荐系统改进

通过分析用户-物品二分图,Graph Transformer可以揭示隐藏的兴趣模式,提供更加个性化的推荐结果。比如音乐流媒体服务可以根据听众的历史播放记录为其推荐相似风格的新歌单。

常见问题及解决方案 ❓

Q1: 如何处理大规模图数据?

当面对数百万甚至数十亿节点的超大型图时,传统的全图加载方式显然不可行。此时可以考虑采用子图采样或者分布式计算框架(如DGL、PyTorch Geometric Lightning)来分割任务,逐步完成整个图的学习过程。

Q2: 遇到冷启动问题怎么办?

对于新加入系统的实体(如刚注册的用户),由于缺乏足够的历史信息,直接应用Graph Transformer可能会导致效果不佳。为此,可以在模型中引入一些先验知识(如人口统计学特征)作为补充,或者借助转移学习从相关领域获取经验。

Q3: 如何评估模型性能?

除了常见的准确率、召回率指标外,还可以参考AUC-ROC曲线下的面积、F1分数等综合评价标准。此外,针对特定应用场景,设计合理的业务导向型KPI也是十分必要的。

实用技巧与提示 ✨

调试与验证

开发过程中应建立严格的测试流程,包括单元测试、集成测试以及端到端测试,确保各个部分都能正常运作。同时,积极收集反馈意见,不断优化现有方案。

性能调优

根据硬件资源状况合理配置超参数,如批处理大小、学习率等;探索不同的初始化方法和激活函数组合;尝试多种正则化手段找到最佳平衡点。

社区交流

积极参与国内外知名的技术论坛(如GitHub Issues、Stack Overflow),与其他开发者分享经验和心得。订阅相关领域的顶级期刊杂志,保持对前沿研究的关注度。

结论

通过对Graph Transformer算法及其工程应用的详细讲解,我们不仅了解到了这种先进模型背后的理论基础,还掌握了如何将其应用于解决实际问题的具体步骤。希望这篇文章能为你带来新的思路和技术支持。如果有任何疑问或需要进一步的帮助,请随时留言讨论!💬

暂无评论内容