内容目录

- • 锁消除的概念及原理 🔍

- —— 什么是锁消除?

- —— 锁消除的工作机制

- • 锁粗化的概念及应用 ⚙️

- —— 什么是锁粗化?

- —— 锁粗化的实现方式

- • 实践中的性能优化技巧 ✨

- —— 减少锁争用

- —— 使用无锁数据结构

- —— 分离热点区域

- • 常见问题及解决方案 ❓

- —— Q1: 如何验证锁消除是否生效?

- —— Q2: 锁粗化会不会导致死锁风险增加?

- —— Q3: 性能调优过程中遇到瓶颈怎么办?

- • 结论

在多线程环境中,正确处理同步问题对于确保程序的正确性和性能至关重要。Java虚拟机(JVM)提供了多种机制来帮助开发者管理线程间的协作,其中“锁消除”和“锁粗化”是两个重要的优化技术。本文将详细探讨这两个概念,并介绍如何利用它们来提升应用程序的并发性能。

![图片[1]-深入解析锁消除与锁粗化:Java并发编程中的性能优化利器-连界优站](https://www.6x66.cn/wp-content/uploads/2024/11/image-40.png)

锁消除的概念及原理 🔍

什么是锁消除?

锁消除是指JVM在运行时自动识别那些实际上不会被多个线程同时访问的对象或代码段上的锁,并将其移除的过程。这种优化可以减少不必要的同步开销,从而提高执行效率。

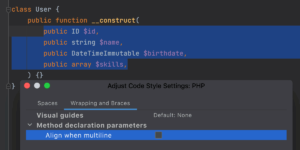

锁消除的工作机制

JVM会通过一系列静态分析和动态检测手段来判断某个锁是否真的有必要存在。如果确定该锁仅在一个线程内使用,或者其作用范围非常有限,则可以选择性地忽略它。具体来说:

- 逃逸分析:检查对象是否有可能从当前方法或线程中“逃逸”出去,即被其他线程引用。

- 局部变量锁定:当一个锁只用于保护局部变量时,通常可以安全地消除。

锁粗化的概念及应用 ⚙️

什么是锁粗化?

锁粗化指的是JVM将多次连续的加锁操作合并成一次较长时间的持有过程。这有助于避免频繁地获取和释放锁带来的额外负担,尤其是在循环体内重复执行相同同步逻辑的情况下特别有用。

锁粗化的实现方式

为了达到最佳效果,JVM会在编译期间尝试识别出那些可能适合进行锁粗化的场景。例如,在以下代码片段中:

for (int i = 0; i < iterations; i++) {

synchronized (lock) {

// 同步代码块

}

}JVM可能会优化为:

synchronized (lock) {

for (int i = 0; i < iterations; i++) {

// 同步代码块

}

}这样的改动不仅减少了锁竞争的可能性,还能显著降低上下文切换的成本。

实践中的性能优化技巧 ✨

减少锁争用

尽量缩小临界区的范围,只对真正需要保护的数据部分施加同步控制。此外,考虑使用读写锁(ReentrantReadWriteLock),允许更多的并发读取操作而不影响写入者的独占性。

使用无锁数据结构

引入原子类(如AtomicInteger、AtomicReference等)代替传统的同步机制,可以在某些情况下完全避免显式锁定。这些类基于硬件级别的CAS(Compare-and-Swap)指令实现了高效的并发更新。

分离热点区域

将经常被不同线程访问的共享资源分离出来,分别进行独立的同步处理。比如,采用分段锁策略(Segmented Locking),把大集合拆分成若干个小集合,每个小集合对应一个单独的锁。

常见问题及解决方案 ❓

Q1: 如何验证锁消除是否生效?

可以通过开启JVM的日志输出功能,查看是否存在相关的优化提示信息。例如,添加参数-XX:+PrintEliminateLocks后,JVM会在启动时打印有关锁消除的结果。

Q2: 锁粗化会不会导致死锁风险增加?

理论上讲,过度粗化确实可能引发潜在的死锁问题。因此,在实际应用中应当谨慎评估每个具体情况,权衡利弊后再做决定。另外,保持良好的代码设计习惯,如尽量缩短同步代码块长度,也可以有效降低此类风险。

Q3: 性能调优过程中遇到瓶颈怎么办?

当常规优化措施无法满足性能需求时,不妨借助专业的性能分析工具(如VisualVM、JProfiler等)深入诊断问题所在。同时,不要忽视数据库查询效率和网络延迟的影响,综合考虑各方面因素才能找到最合适的解决方案。

结论

通过深入了解锁消除与锁粗化的原理及其应用场景,我们能够在开发过程中更加灵活地运用这两种技术来优化Java并发程序的性能。希望这篇文章对你有所帮助,如果你有任何疑问或需要进一步的帮助,请随时留言讨论!💬

暂无评论内容