在今天的数据驱动世界中,ETL(抽取、转换、加载)过程是数据工程中至关重要的一环。Pentaho Kettle(现在称为Hitachi Vantara Pentaho Data Integration)是一个功能强大且开源的工具,用于处理和转换数据。本文将介绍如何在Linux服务器上部署Kettle并设置定时任务,以实现自动化的数据ETL流程。

![图片[1]-使用Linux部署Kettle并设置定时任务 – 数据ETL的得力助手-连界优站](http://www.6x66.cn/wp-content/uploads/2023/09/image-101.png)

步骤一:下载和安装Kettle

- 首先,访问Pentaho官方网站,下载最新版本的Kettle(Pentaho Data Integration)二进制文件。

- 将下载的文件上传到你的Linux服务器上,可以使用SCP或其他文件传输工具。

- 解压下载的文件,进入Kettle目录:

tar -xzf pentaho-data-integration-<version>.zip

cd pentaho-data-integration- 运行Kettle:

./spoon.sh这将启动Kettle的图形用户界面(GUI),你可以使用它来创建和测试ETL作业和转换。

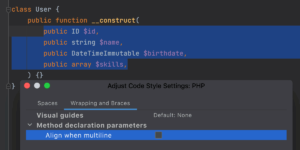

步骤二:创建Kettle ETL作业和转换

- 使用Kettle的GUI创建所需的ETL作业和转换。这可以包括数据抽取、转换、加载和其他数据处理任务。

- 测试你的ETL作业和转换,确保它们按预期工作。

步骤三:设置定时任务(Cron Job)

要定期运行Kettle ETL作业,你可以使用Linux的定时任务工具Cron。以下是如何设置Cron作业:

- 打开Cron配置文件:

crontab -e- 在文件底部添加一个新的定时任务。以下是一个例子,每天凌晨1点运行Kettle作业:

0 1 * * * /path/to/pentaho-data-integration/kitchen.sh -rep=your_repository -job=your_job -dir=your_directory请确保替换 /path/to/pentaho-data-integration 为你的Kettle安装路径,以及 your_repository、your_job 和 your_directory 为你的作业和目录的名称。

0 1 * * *表示每天的1点运行任务。你可以根据需要修改此时间表。/path/to/pentaho-data-integration/kitchen.sh是Kettle的运行脚本。-rep=your_repository -job=your_job -dir=your_directory参数指定了要运行的Kettle作业的相关信息。

- 保存并退出文件。Cron将根据你的时间表自动运行Kettle作业。

步骤四:监控和维护

确保定期监控你的定时任务和Kettle作业的运行情况。如果需要,可以设置日志记录以便跟踪问题并进行维护。

结论

通过在Linux上部署Kettle并设置定时任务,你可以自动化数据ETL流程,确保数据的及时处理和加载。这个过程使你能够更有效地处理大量的数据,并确保数据可用性。Kettle的灵活性和强大功能使它成为数据工程师和分析师的得力助手,帮助他们管理和转换数据以满足业务需求。