谷歌蜘蛛是谷歌搜索引擎的爬虫程序,用于收集和索引网页内容。然而,有时候您可能希望限制谷歌蜘蛛访问您的网站,可能是出于隐私、安全或其他原因。在本教程中,我将向您展示如何禁止谷歌蜘蛛搜索引擎访问您的网站。

请注意,这将只是禁止谷歌蜘蛛的访问。其他搜索引擎的爬虫可能仍然可以访问您的网站。如果您想禁止其他搜索引擎的爬虫,您需要根据相应的指南进行设置。

![图片[1]-如何禁止谷歌蜘蛛搜索引擎访问您的网站-连界优站](http://www.6x66.cn/wp-content/uploads/2023/08/image-212.png)

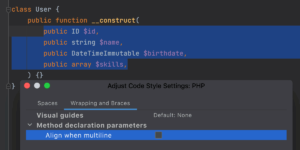

方法一:通过robots.txt文件

- 打开您网站的根目录,找到或创建一个名为

robots.txt的文本文件。 - 在

robots.txt文件中,添加以下内容以禁止谷歌蜘蛛访问您的网站:

User-agent: Googlebot

Disallow: /这会告诉谷歌蜘蛛不要访问您网站的任何页面。

- 保存并上传

robots.txt文件到您网站的根目录。 - 检查是否已成功禁止谷歌蜘蛛访问。您可以使用谷歌搜索控制台中的”URL检查工具”来验证。

方法二:通过网页的HTML元标签

- 找到您网站首页的HTML文件。

- 在

<head>标签内添加以下元标签:

<meta name="robots" content="noindex, nofollow">这将指示搜索引擎不要索引您的网站,并且不要跟踪其中的链接。

- 保存并上传修改后的HTML文件到您的服务器。

方法三:使用HTTP响应头

- 打开您的网站服务器上的

.htaccess文件(如果不存在,可以创建一个)。 - 在文件的末尾添加以下行来设置HTTP响应头,阻止搜索引擎的访问:

Header set X-Robots-Tag "noindex, nofollow"- 保存

.htaccess文件并上传到您的服务器。

请注意,以上方法中的任何一个都可以用于禁止谷歌蜘蛛访问您的网站,但无法保证其他搜索引擎是否会遵守相同的规则。如果您希望禁止其他搜索引擎的爬虫访问您的网站,您需要根据相应搜索引擎的指南进行设置。

总之,禁止搜索引擎的蜘蛛访问是一个有效的方式来控制您网站的内容展示。然而,请谨慎使用此功能,以免影响您网站的可见性和流量。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END