内容目录

在现代软件系统中,日志数据是宝贵的信息源,它可以提供关于系统运行状态、错误和用户行为等方面的重要见解。MongoDB作为一种受欢迎的NoSQL数据库,也会产生大量的日志数据。为了更好地监控和分析MongoDB的日志,将其集成到ELK(Elasticsearch、Logstash和Kibana)堆栈中是一个高效的解决方案。本文将介绍如何使用ELK Logstash来无缝处理MongoDB日志,实现高效的日志分析和可视化。

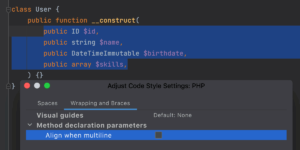

![图片[1]-无缝整合:使用ELK Logstash处理MongoDB日志的高效方法-连界优站](http://www.6x66.cn/wp-content/uploads/2023/08/image-43-1024x482.png)

ELK Logstash:简介与优势

ELK堆栈是一组强大的工具,用于收集、存储、分析和可视化各种类型的日志数据。其中,Logstash作为数据收集和传输的关键组件,具有丰富的插件和功能,使其成为整合MongoDB日志的理想选择。

Logstash优势:

- 灵活的数据收集: Logstash支持多种输入插件,可以从各种来源收集数据,包括文件、网络流、数据库等。

- 数据转换和过滤: Logstash的过滤器插件可以对收集到的数据进行转换、过滤和格式化,使其变得更易于分析和可视化。

- 多种输出选项: Logstash支持将处理后的数据输出到不同的目标,如Elasticsearch、文件、消息队列等。

将MongoDB日志集成到ELK Logstash

以下是将MongoDB日志集成到ELK Logstash的步骤:

步骤1:安装和配置Logstash

- 下载并安装Logstash:前往Logstash官方网站,下载适用于您操作系统的安装包,并按照指南进行安装。

- 创建Logstash配置文件:在Logstash配置文件中,定义MongoDB作为输入源,并根据日志格式配置解析方式。

步骤2:配置Logstash过滤器

- 使用grok过滤器:对MongoDB的日志进行解析和过滤,使用grok过滤器可以根据日志的模式将日志字段提取出来。

- 应用其他过滤器:根据需要,可以使用其他Logstash过滤器,如mutate和date等,对数据进行格式化和处理。

步骤3:输出到Elasticsearch

在Logstash配置文件中,配置Elasticsearch作为输出目标。将经过处理的MongoDB日志数据发送到Elasticsearch进行存储和索引。

步骤4:数据分析和可视化

- 安装和配置Kibana:下载并安装Kibana,配置Kibana连接到Elasticsearch。

- 创建可视化仪表板:使用Kibana创建图表、图形和仪表板,展示MongoDB日志的关键指标和趋势。

结论

通过将MongoDB日志集成到ELK Logstash中,您可以实现对日志数据的集中收集、解析、过滤和可视化。这不仅有助于监控系统的健康状态和问题排查,还可以帮助您更好地理解用户行为、系统性能和趋势。Logstash的灵活性和功能丰富性使其成为处理MongoDB日志的理想选择。通过深入了解ELK Logstash的配置和功能,您将能够构建高效的日志分析和可视化解决方案,提升系统的可靠性和性能。